Il y a quelques mois maintenant, j’avais publié sur Joptimisemonsite une série de tests a/b que j’avais réalisé pour améliorer les taux de clics sur les différentes mises en avant que je réalisais à l’époque sur le site 01net.

J’ai eu envie de revenir dessus aujourd’hui car j’ai eu l’occasion de discuter de ces tests avec certains des e-commerçants que j’accompagne au quotidien. Et le moins que l’on puisse dire, c’est qu’ils ne sont pas réellement au fait des règles à respecter pour que les tests a/b qu’ils réalisent soient utiles et surtout fiables.

Je vous propose aujourd’hui de répondre l’une des questions les plus répandues en matière d’a/b testing : quand faut-il arrêter un test a/b ? Ou dit autrement, quand peut-on se dire qu’un test a/b est suffisamment fiable pour qu’on puisse le stopper ?

Lire également: chronique d’un test MVT raté

Qu’est-ce qu’un test a/b ?

Un test a/b mesure l’écart de performance entre deux versions d’une même page web. On parle alors de variantes : une page A que l’on met en compétition avec une page A bis, sur laquelle on a modifié un élément.

Une variante peut-être une nouvelle page, une modification apportée à la page, un message.

L’utilisateur se pose légitimement la question de l’arrêt de cette campagne afin de la proposer à l’ensemble du trafic et où de la passer dans le code de la page

À quel moment faut-il arrêter un test a/b.

Une des questions les plus fréquentes lorsque l’on fait de l’a/b testing est la question de la significativité des résultats. Ces mots barbare signifient simplement « à quel moment faut-il arrêter un test a/b en cours ? »

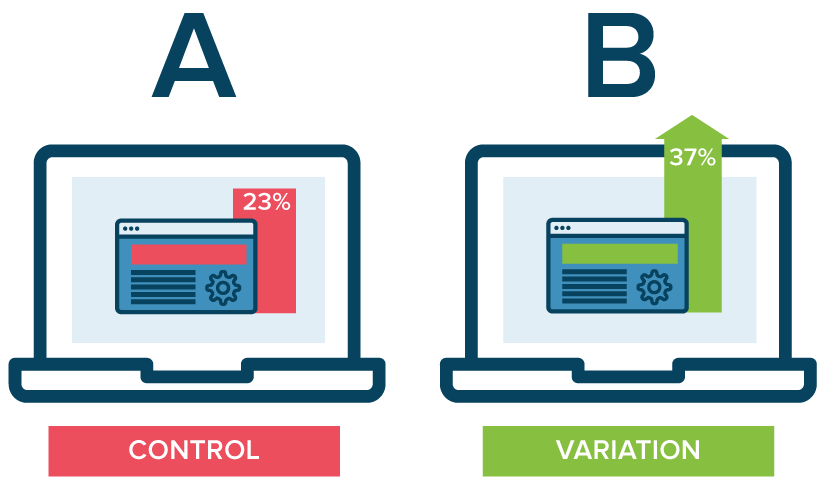

Le taux de confiance d’un test a/b

Le taux de confiance d’un test a/b, c’est simplement le taux de signification statistique du test. Un test a/b est jugé fiable lorsqu’il atteint un niveau de confiance de 95%. Celui peut donc être stoppé.

Ce taux de confiance se base principalement sur deux facteurs : la taille de l’échantillon et l’écart de taux de conversion entre la variante est l’original.

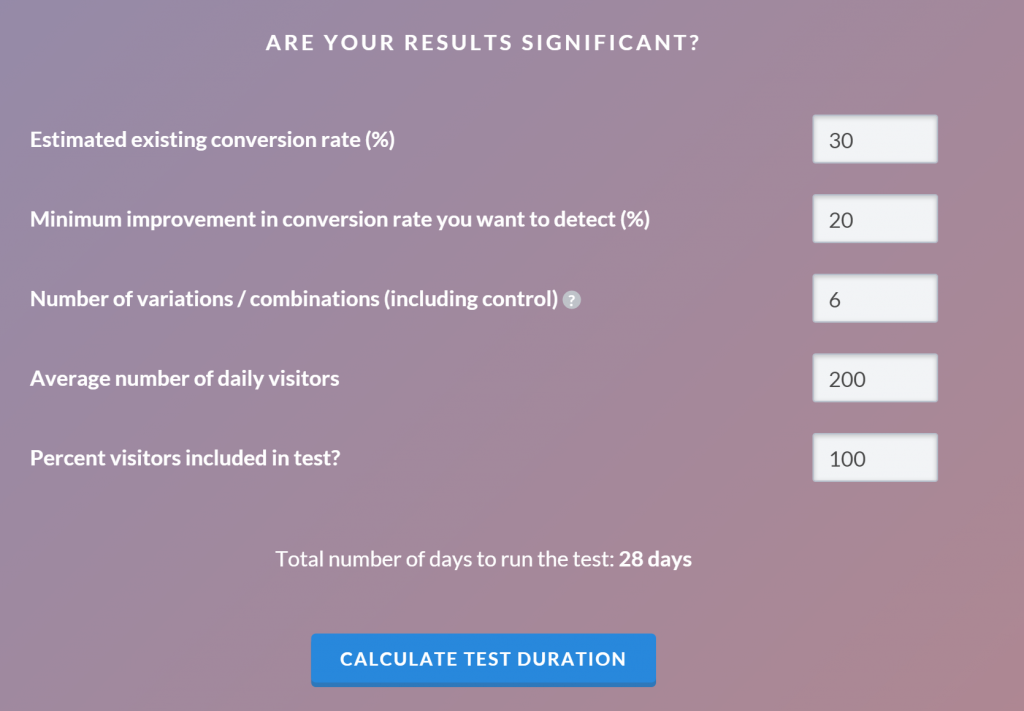

La bonne nouvelle, c’est qu’il existe des calculatrices qui vous font une estimation du nombre de jour qu’il vous faudra laisser votre test en ligne pour qu’il atteigne le taux de confiance optimal.

La durée, ça compte

N’en déplaise aux hommes, la durée ça compte ! En effet, la durée d’un test A/B doit être supérieure à 2 semaines.

Mais alors pourquoi autant de temps pour arrêter un test a/b alors que certains sites ont des millions de visiteurs quotidien ? Il s’agit simplement de corriger les variations d’activité qui peuvent être enregistrées au cours d’une même semaine.

Par exemple une plus forte fréquentation le week-end, une météo changeante, des promotions sur un site concurrent, un bug momentané sur le site,…

Si plus rien ne bouge, vous touchez au but !

L’absence de variation pendant au moins 7 jours pourra vous permettre d’arrêter votre test.

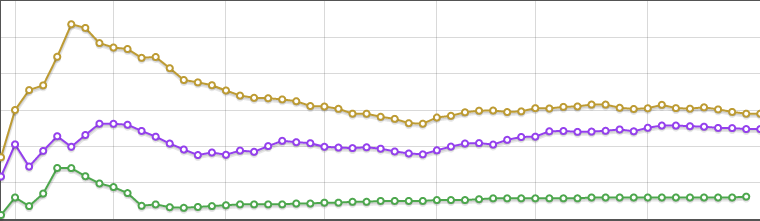

En effet, une fois que l’échantillon est significatif, les 2 courbes (taux de conversion cumulés) des visiteurs qui voient la variante A et de ceux qui voient la variante B ont tendance devenir parallèle dans la durée.

Cette stabilisation et un signe fort que l’on a atteint un niveau de significativité important et que le test A/B peut être arrêté sereinement.

Le nombre de conversion, votre meilleur indicateur !

Atteindre au moins 150 conversions est le quatrième critère à considérer. En effet, au début d’un test, on observe de très fortes variations de la performance et donc de l’écart entre les variantes A et B. Ceci c’est complètement normal, et surtout non significatif.

Pour l’expliquer, le plus simple c’est de prendre l’exemple du casino : la bille peut s’arrêter huit fois de suite sur le rouge, cela ne signifie pas pour autant que le rouge n’a pas une probabilité de 50% (ou légèrement inférieure pour les connaisseurs 😉