Vous qui lisez Joptimisemonsite régulièrement, vous savez que j’ai une doctrine qui me suis depuis que je travaille en webmarketing: tester, tester et encore tester ! Et qui dit « tester », dis « a/b testing ».

Pour rappel, j’ai publié il y a quelques mois maintenant le résultats d’a/b tests que j’avais réalisé lorsque j’étais Responsable E-commerce chez Next Interactive (BFM TV, RMC, 01net) qui avaient vocation de vous démontrer que:

- Oui, les images ont un impact sur le taux de clic d’une campagne de communication

- Oui, le texte joue également un rôle important dans la réactivité d’une campagne

- Oui, il est nécessaire de tester le wording et la couleur du bouton d’action d’une campagne

Aujourd’hui, j’avais envie de vous sensibiliser sur le fait que de faire des a/b tests est importants, mais qu’il ne faut pas faire n’importe quoi dans l’utilisation des données qui en résultent.

Et pour appuyer mon propos, je vais vous faire le retour d’un test que j’ai actuellement mis en place pour le compte d’un organisme de formation parisien en utilisant le module d’a/b testing de Beampulse.

Les 3 phases d’un test a/b

J’en arrive donc au sujet de mon article: lorsque vous faîtes des tests a/b, attention aux conclusions de tests trop hâtives !

En préambule, je dois vous rappelez qu’il y a, selon moi, 3 phases distinctes lorsqu’on effectue un test a/b:

- Le lancement du test: les courbes sont très volatiles car les volumes testés sont encore trop faibles: chaque nouvelle conversion (c’est à dire un clic sur un bouton d’ajout au panier dans mon cas) a un impact sur les courbes.

- La phase de stabilisation: Puis, du fait que les volumes augmentent, les courbes se stabilisent et une première tendance émerge.

- La phase de confirmation/solidification: Plus les volumes augmentent, plus on réduit l’impact que peuvent avoir ceux qu’on appelle les « moutons noirs », c’est à dire les internautes qui ne réagissent pas comme la moyenne. La phase de solidification (confirmation) des résultats permet de vérifier la première tendance et de s’assurer que les résultats sont fiables.

Présentation du cas pratique

Pages concernées par l’a/b test: fiches produits

Constat: a première vue, il n’y a aucun élément de réassurance ni d’arguments commerciaux présents au-dessus de la ligne de flottaison sur les fiches produits de l’organisme de formation.

Objectif du test: mesurer l’impact de l’ajout de réassurance et d’arguments commerciaux sur le taux d’ajout au panier des produits vendus

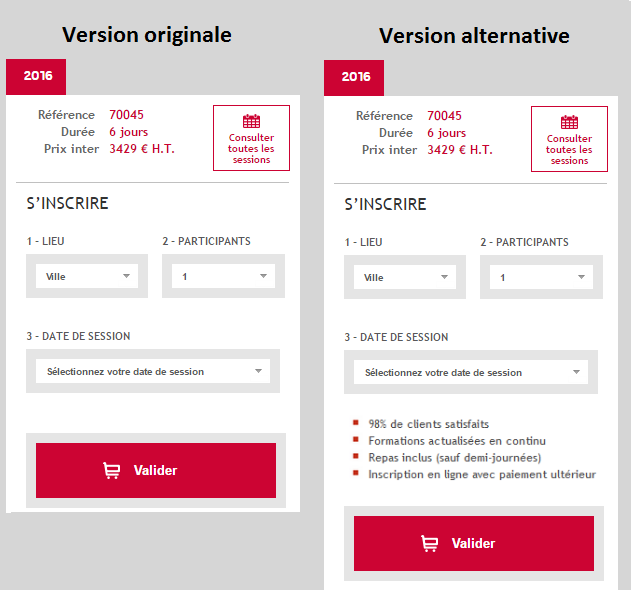

Version originale et variante:

Comme vous pouvez le remarquer, j’ai positionné un encart de réassurance et d’arguments commerciaux entre le choix de la date de session de formation et le bouton « valider ».

Comme vous pouvez le remarquer, j’ai positionné un encart de réassurance et d’arguments commerciaux entre le choix de la date de session de formation et le bouton « valider ».

Répartition du trafic: 50-50

Quel était le résultat de mon a/b test ?

Le plus simple pour vous présenter les résultats, c’est de vous livrer les courbes d’évolution deux versions. Ces courbes vous présentent l’évolution du taux de clic sur le bouton d’action:

La courbe verte correspond à la version originale. La courbe orange est donc liée aux statistiques de la version alternative, celle qui comprend les arguments commerciaux/réassurance.

Comme vous pouvez le voir, on peut bien voir la première phase avec des courbes très volatiles. On voit ensuite que les courbes se rapprochent et se croisent même (1 rond rouge) pour commencer la phase de stabilisation.

Et c’est là où cela devient dangereux pour quelqu’un qui débute en a/b testing. En effet, la partie que vous voyez dans le rectangle bleu est plutôt stable. Dans le rond gris, la version alternative avait même un taux de clic de plus de +50% par rapport à la version originale: mon hypothèse était donc bonne ! ERREUR !

En effet, comme je l’évoquais plus haut, les volumes étaient déjà conséquents mais pas suffisant pour réduire la marge d’erreur provoquée par les internautes moutons noirs ! A tel point que les deux courbes se sont touchées quelques jours/semaines plus tard, comme vous pouvez le voir dans le second rond rouge.

Bon, il s’avère que la courbe orange est repartie à la hausse et semble s’être stabilisée depuis aux alentours de +15%. Mais si j’avais arrêté le test trop tôt car sûr de mon fait (par exemple lors du rond gris), j’aurais pu passé à côté d’une information cruciale (par exemple si la version originale avait finalement repris le dessus sur la version alternative). Alors méfiez-vous et respectez bien les 4 critères qui définissent qu’un test a/b peut être arrêté car jugé fiable.